Apple, gelen eleştirilerin ardından, çocukların cinsel istismara uğramaması adına iCloud’daki görüntüleri tarama kararından şimdilik vazgeçtiğini duyurdu. Apple ’ın geliştirdiği ‘Çocukların Cinsel İstismarı Malzemesi’ (CSAM) tespit araçları gizlilik savunucuları arasında endişeye neden olmuştu.

Apple’ın geçen haftalarda gündeme bomba gibi düşen yeni araçlarının kullanıma sunulması kararı ertelendi. Şirketin çocuklara yönelik cinsel tacizle mücadele amacıyla iCloud’daki görüntüleri tarayacağı haberi beraberinde eleştirileri getirmişti. Pek çok kişi şirketin bu kararının kullanıcı gizliliğine ket vuracağını belirterek geri çekilmesini istemişti. Apple, aldığı tepkilerin ardından araçlarını kullanıma sunmayacağını açıkladı.

Apple ek zaman istedi

Apple, yaptığı bir açıklamada: “Geçen ay, çocukları, onları işe almak ve sömürmek için iletişim araçlarını kullanan yırtıcılardan korumaya ve Çocukların Cinsel İstismarı Materyalinin yayılmasını sınırlamaya yardımcı olmayı amaçlayan özellikler için planlarımızı duyurduk. Müşterilerden gelen geri bildirimlere dayanarak, savunuculuk grupları, araştırmacılar ve diğerleri, kritik öneme sahip bu çocuk güvenliği özelliklerini yayınlamadan önce girdi toplamak ve iyileştirmeler yapmak için önümüzdeki aylarda ek zaman ayırmaya karar verdik.” ifadelerini kullandı.

Apple’ın iOS 15, iPadOS 15, watchOS 8 ve macOS Monterey gibi yaklaşan işletim sistemi güncellemelerinin bir parçası olan ‘Child Sexual Abuse Material’ (CSAM) yani ‘Çocukların Cinsel İstismarı Malzemesi’ araçlarını kullanıma sunacaktı. Şirketin birkaç hafta içinde özelliği devreye sokması bekleniyordu.

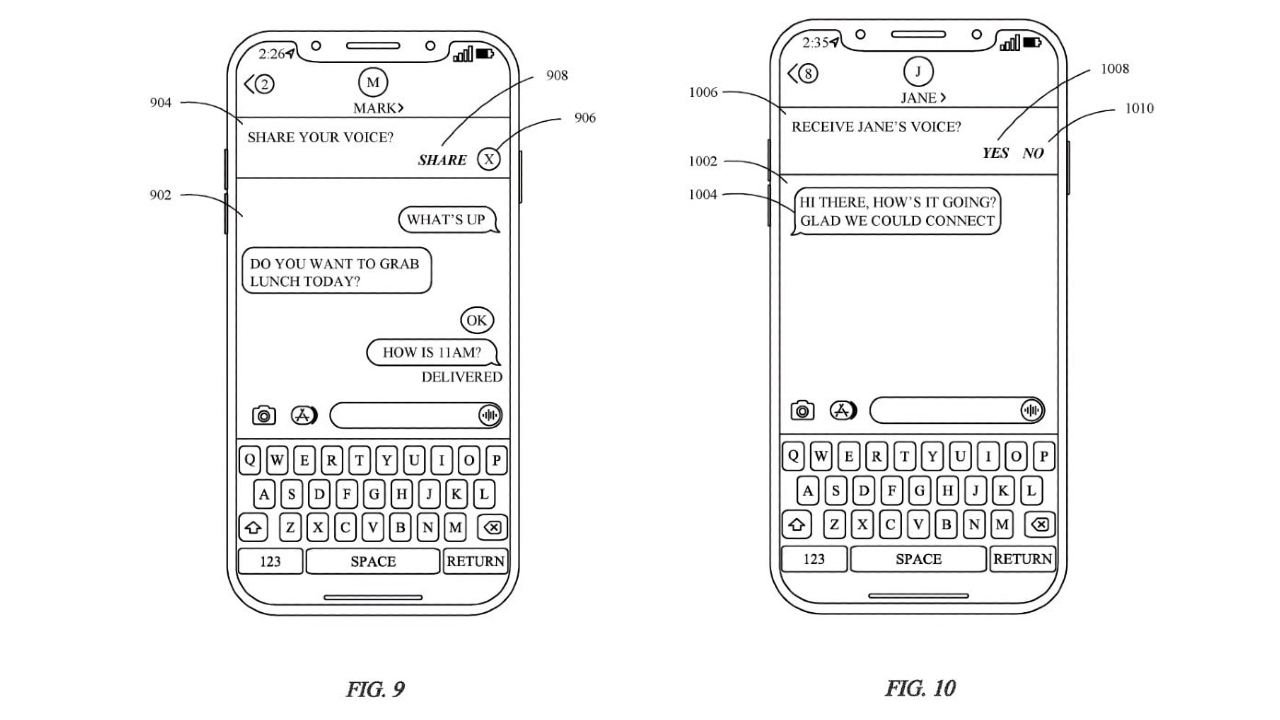

Apple’ın ertelediği yeni özellikler arasında, cihazdaki makine öğrenimi sistemleri kullanılarak uygulamada cinsel içerikli fotoğrafların paylaşıldığı algıladığında çocukları ve ebeveynlerini bilgilendirecek olan Mesajlar için bir özellik vardı. Çocuklara gönderilen bu tür görüntüler bulanık olacak ve uyarılar içerecekti.

iCloud Fotoğrafları aracı, Apple’ın duyurduğu CSAM algılama özellikleri arasında belki de en tartışmalı olanı oldu. Apple, CSAM görüntülerini, Ulusal Kayıp ve İstismara Uğrayan Çocuklar Merkezi ile diğer kuruluşlarla karşılaştıracak ve veritabanında eşleyecekti. Bu analizin, bir görüntü iCloud Photos’a yüklenmeden önce gerçekleşmesi gerekiyor. CSAM’i tespit edecek sistem söz konuus bir görüntü gördüğünde Apple kişinin hesabını devre dışı bırakıp ve NCMEC’e bir rapor gönderecekti.

Apple, yaklaşımın “mevcut tekniklere göre gizlilik avantajları sağlayacağını, çünkü yalnızca iCloud Fotoğrafları hesaplarında bilinen bir CSAM koleksiyonu varsa, kullanıcıların fotoğraflarını öğrendiğini” iddia etti. Bununla birlikte, gizlilik savunucuları planlanan hareket konusunda kolları sıvadı.

Hem gizlilik hem güvenlik amacıyla eleştiri

Bazıları, CSAM fotoğraf taramasının kolluk kuvvetlerine veya hükümetlerin Apple’ı, örneğin muhalifleri baskı altına almak için başka tür görseller aramaya itmesine yol açabileceğini öne sürüyor. Teknolojiyi “tehlikeli” olarak adlandıran benzer bir sistem kurduklarını söyleyen iki Princeton Üniversitesi araştırmacısı . Şunları yazdılar: “Sistemimiz, gözetleme ve sansür için kolayca yeniden kullanılabilir. Tasarım, belirli bir içerik kategorisiyle sınırlı değildi; bir hizmet, herhangi bir içerik eşleştirme veritabanında kolayca değiş tokuş yapabilir ve bu hizmeti kullanan kişi bundan daha akıllı olamaz.”

Apple, Ağustos ayının ortalarında duyurduğu özellikler hakkında kafa karışıklığına yol açtığını söylüyor. Şirketin yazılım mühendisliği kıdemli başkan yardımcısı Craig Federighi, görüntü tarama sisteminin “birden fazla denetlenebilirlik düzeyine” sahip olduğunu belirtti. Öyle olsa bile, Apple yaklaşımını yeniden düşünüyor. Özelliklerin kullanıma sunulması için yeni bir zaman çizelgesi ise açıklamadı.

İlginizi Çekebilir:

Amazon İstedi Apple O Uygulamayı Kaldırdı

Mahkemeden Apple Türkiye’ye Dijital Miras Talebi!

Poco X3 Pro PUBG , Asphalt 9, Mortal Kombat, UFC, Ark Survival Evolved ile oyun testi: